Mini-Omni 是我们产品正在进行接入的

AI能力,这是一个开源的多模态大语言模型,可以在语音对话时,边听边思考边说。

开源地址:https://github.com/gpt-omni/mini-omni

Mini-Omni 是一个创新的开源项目,它将大语言模型与实时语音处理技术相结合,为语音交互技术带来了新的突破,让你的设备不仅能 “ 看懂 ” 你的文字,还能 “ 听懂 ” 你的话,并用声音与你交流。为用户提供了一个既能理解文本又能处理语音的智能平台,让你拥有一个能即时声音回应的智能伙伴。

项目亮点:

- 支持实时端到端语音输入和流式音频输出的对话能力。

- 无需额外的 ASR 或 TTS 模型。

- 支持在思考的同时进行语音输出,能够同时生成文本和音频。

- 支持流式音频输出。

- 支持 音频到文本 和 音频到音频 批量推理,以进一步提高性能。

Mini-Omni 的亮点在于其端到端的语音对话能力,这意味着它能够直接处理语音输入并生成语音输出,而无需依赖于独立的自动语音识别(ASR)或文本到语音(TTS)系统。这种一体化的设计极大简化了语音交互系统的开发流程,使得开发者能够更专注于创造更自然、更流畅的语音内容用户体验。

此外,Mini-Omni 的流式音频输出功能,为实时通信技术的应用提供了新的可能性。无论是在线会议、远程教育还是在线咨询,Mini-Omni 都能提供稳定而高效的语音交互支持。

对于语音和语言处理领域的专业人士而言,Mini-Omni 提供了一个理想的实验平台。它不仅得到了 Hugging Face 和 OpenAI's Whisper 等权威机构的工具和模型的支持,增强了其可信度和潜在实用性。

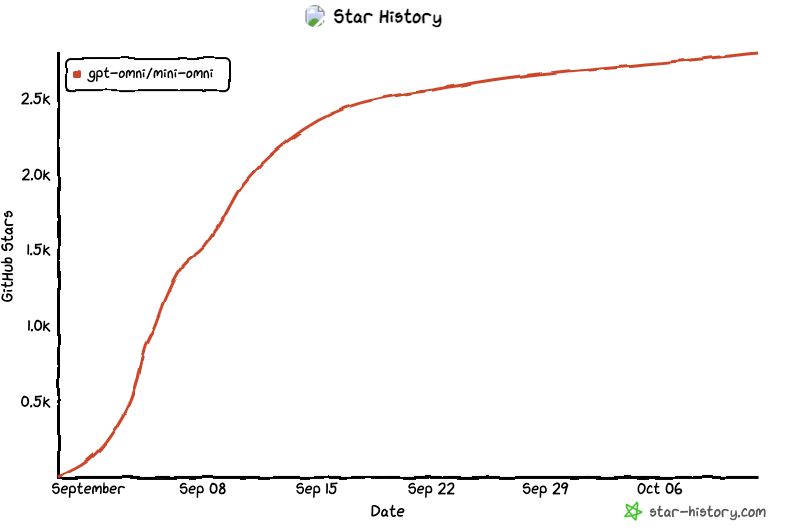

Mini-Omni 将是一个有价值的资源,��为那些希望深入研究语音和语言人工智能交叉领域的人士使用,而无需面对专有软件的障碍。上线Github 两个月一来,目前已斩获 2.8K 星,且正在快速增加中。

关联依赖:

- Qwen2 作为 LLM 主要基座。

- litGPT 用于训练和推理。

- whisper 用于音频编码。

- snac 用于音频解码。

- CosyVoice 用于生成合成语音。

- OpenOrca 和 MOSS 用于对齐。